Ollama

Ollama 是一个开源的本地大语言模型(LLM)管理和运行框架,旨在让开发者、研究人员和普通用户能够在本地计算机上轻松部署、管理和交互各种大型语言模型,而无需依赖云端服务。

Ollama 降低了本地运行大模型的门槛,非常适合开发者入门大模型应用开发。其易用性、灵活的 API 和活跃的社区生态,使其成为本地 AI 部署的重要工具。

以下是其主要特点及功能:

- Ollama 支持在本地计算机上运行多种开源大模型(如 DeepSeek、Llama、Mistral、Gemma 等),并且提供了不少低配版本方便开发测试。

- 模型管理:提供命令(如 pull, run, list, rm),方便管理各种模型

- 跨平台支持:兼容 Windows、macOS 和 Linux

- API 支持:提供 RESTFul API(默认端口 11434),可像 OpenAI API 一样进行交互,支持流式(stream)和非流式响应

- 提供工具包方便与 Python 代码进行调用

安装 ollama

1、访问 Ollama 官网 先下载、安装 Ollama,然后再使用 Ollama 命令行管理模型。

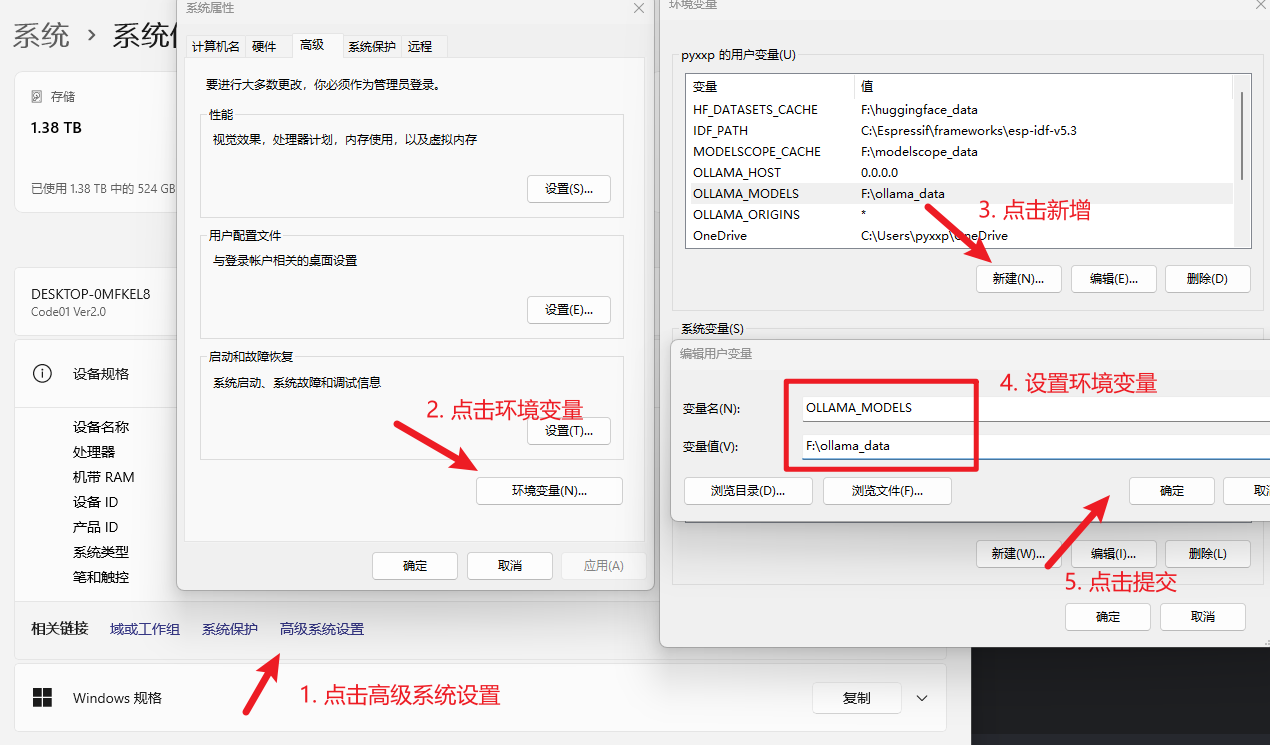

2、安装前修改模型安装路径,否则都会下载在 c 盘

环境变量:

1)变量名:OLLAMA_MODELS,变量值:`[模型存放目录] `

2)变量名:OLLAMA_HOST,变量值:`0.0.0.0`

3)变量名:OLLAMA_ORIGINS,变量值:`*`设置方法:

- 在 Windows 系统桌面中按 Win+Q 键,在搜索框中搜索编辑系统环境变量,单击打开系统属性界面。

- 在系统属性窗口,单击环境变量,然后在系统变量区域下单击新建,变量名填入

[变量名],变量值填入你的[变量值]。

3、双击进行安装,(可以修改安装目录也可以默认)。

4、安装完之后,打开命令提示符,输入 ollama --version,如果出现版本号就表明安装成功。

Ollama 相关命令

Ollama 提供了多种命令行工具(CLI)供用户与本地运行的模型进行交互。

可以用 ollama --help 查看包含有哪些命令:

C:\Users\zhengxin>ollama --help

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.使用方法

ollama [flags]:使用标志(flags)运行 ollama。ollama [command]:运行 ollama 的某个具体命令。可用命令

serve:启动 ollama 服务。

create:根据一个 Modelfile 创建一个模型。

show:显示某个模型的详细信息。

run:运行一个模型。

stop:停止一个正在运行的模型。

pull:从一个模型仓库(registry)拉取一个模型。

push:将一个模型推送到一个模型仓库。

list:列出所有模型。

ps:列出所有正在运行的模型。

cp:复制一个模型。

rm:删除一个模型。

help:获取关于任何命令的帮助信息。

标志(Flags)

-h, --help:显示 ollama 的帮助信息。

-v, --version:显示版本信息。

模型管理

关于模型操作的指令如下

ollama list # 列出当前的所有模型

ollama pull <model-name> # 下拉模型

ollama run <model-name> # 运行模型

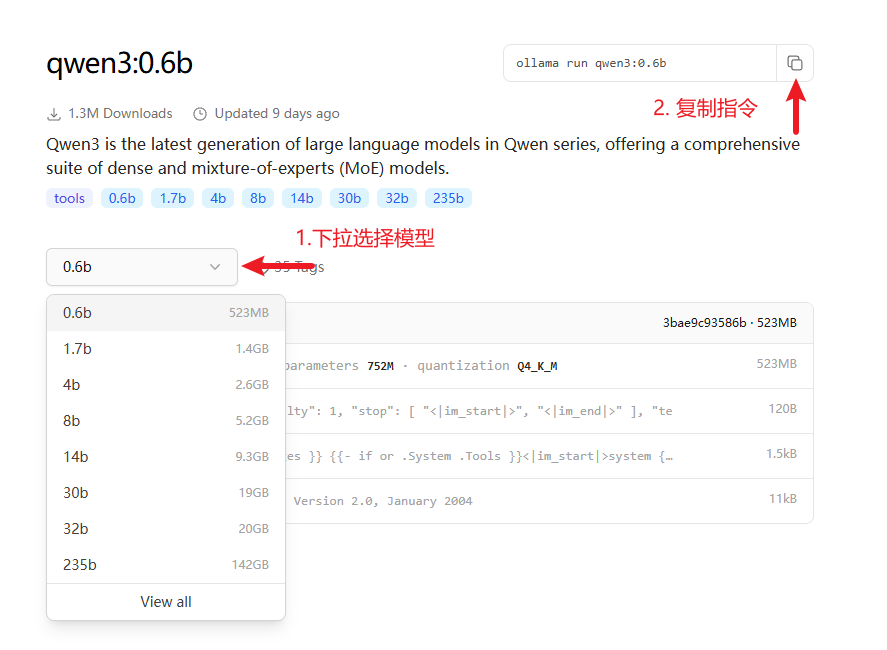

ollama rm <model-name> # 删除模型模型可以在 https://ollama.com/search 查看,可以搜索你想要的模型,然后点击进去。

然后在页面中选择合适大小的模型,复制指令,在命令行中输入进行下载

ollama run qwen3:0.6b运行之后就会自动下载模型,下载完之后就会自动进入交互页面直接操作。

附录

Ollama 文档:https://github.com/ollama/ollama/tree/main/docs

Ollama 有嵌入模型 -> dmeta-embedding-zh